Введение

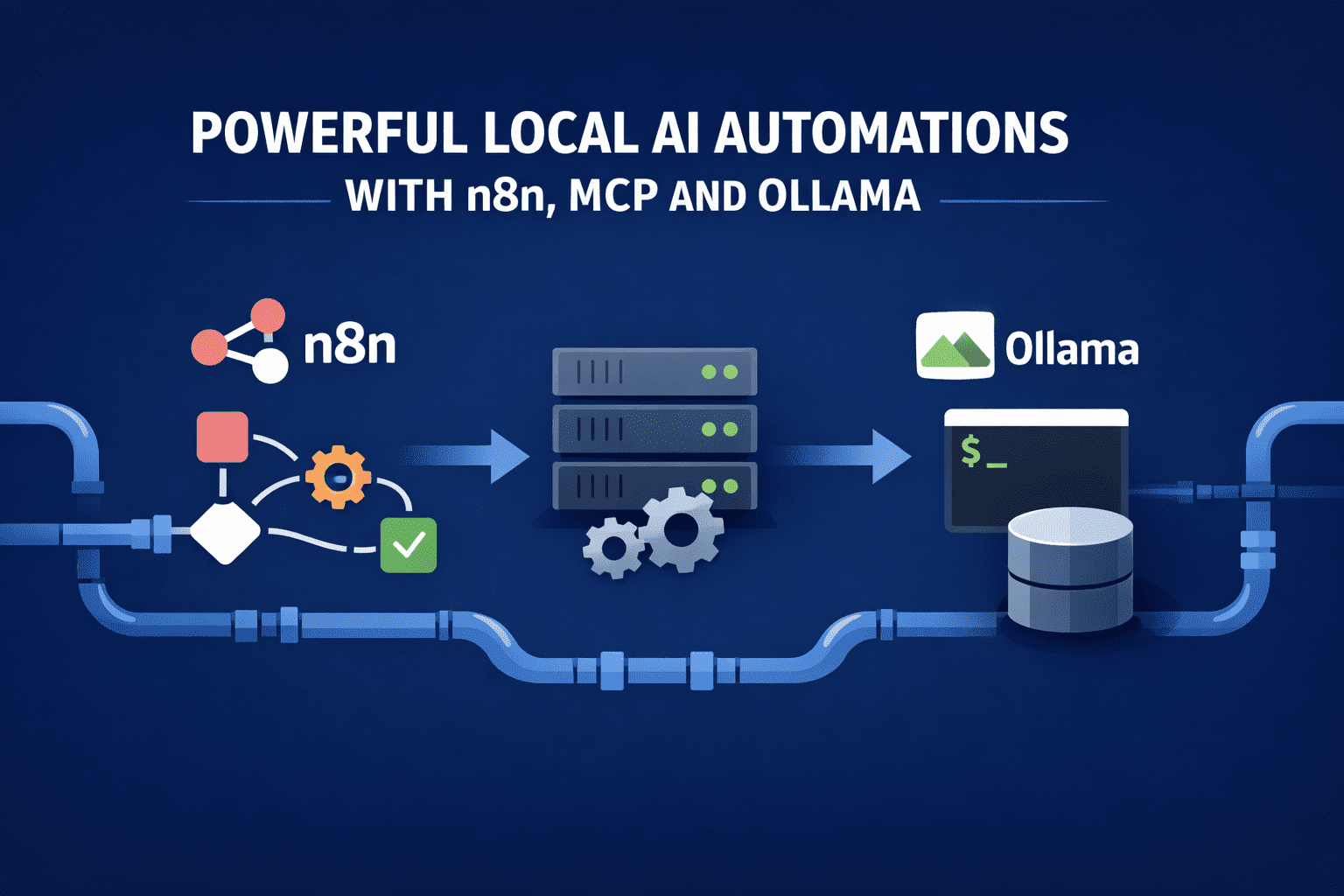

Локальный запуск больших языковых моделей обретает ценность, только если они решают настоящие задачи. Полезность связки n8n, Model Context Protocol (MCP) и Ollama не в изысканной конструкции, а в автоматизации процессов, которые иначе потребовали бы участия инженеров.

Каждый элемент стека несет четкую нагрузку: n8n координирует действия, MCP регулирует доступ к инструментам, Ollama работает с локальными данными.

В итоге такие цепочки запускаются на обычной рабочей станции или компактном сервере, вытесняя нестабильные самописные скрипты и платные облачные сервисы.

Автоматический анализ логов с гипотезами о корневой причине

n8n каждые пять минут забирает логи приложений из локальной папки или через Kafka. Сначала происходит строгая предобработка: сортировка по сервисам, удаление повторов в стек-трейсах, выделение времени и кодов ошибок. Только сжатый пакет уходит к Ollama.

Локальная модель получает узкий промт: сгруппировать сбои, найти начальное событие-триггер и предложить две-три правдоподобные причины. MCP предоставляет один инструмент: query_recent_deployments. При запросе n8n выполняет SQL-запрос к базе развертываний и отдает ответ. Модель корректирует выводы и выдает структурированный JSON.

n8n сохраняет результат, отправляет краткий обзор в Slack и создает тикет, если уверенность выше порога. Облачные модели не задействованы, сырые логи модели не видят.

Непрерывный контроль качества данных в аналитических пайплайнах

n8n следит за поступающими таблицами в локальном хранилище и сравнивает схемы с прошлыми версиями. При отклонениях передается только краткое описание изменения, а не весь набор данных.

Модель определяет, benignое ли это, подозрительное или критическое изменение. MCP дает два инструмента: sample_rows и compute_column_stats. Ollama запрашивает их по необходимости, изучает данные и выдает классификацию с объяснением на людском языке.

При критическом дрейфе n8n останавливает последующие пайплайны и фиксирует выводы модели. Со временем накапливается база прошлых изменений схем с решениями — все локально.

Автономная разметка датасетов и циклы проверки для ML-пайплайнов

Такая цепочка подходит командам, где данные приходят непрерывно, а ручная разметка тормозит. n8n отслеживает локальную директорию или таблицу, собирает пачки неразмеченных записей по расписанию.

Сначала детерминистическая очистка: дубли, нормализация полей, базовые метки — и только потом inference.

Ollama работает с очищенной пачкой и генерирует метки с уровнями уверенности, без свободного текста. MCP ограничивает инструментами для самопроверки: сравнение с историей и семплами. n8n решает: авто-принять, частично или на человека.

Основные шаги цикла:

- Первичная разметка: модель ставит метки и уверенности строго по схеме и примерам, выводит валидируемый JSON для n8n.

- Проверка статистического дрейфа: через MCP модель тянет распределения прошлых меток и отмечает сдвиги, намекающие на концептуальный дрейф или ошибки.

- Эскалация низкой уверенности: n8n отправляет слабые семплы на проверку людям, остальное принимает — скорость на высоте без потери точности.

- Возврат фидбека: правки людей добавляются как новые примеры, доступны модели через MCP в следующих итерациях.

Получается замкнутая система разметки, которая растет локально, учится и минимизирует участие людей.

Самообновляющиеся исследовательские обзоры из внутренних и внешних источников

Цепочка срабатывает ночью. n8n забирает свежие коммиты из репозиториев, внутренние документы и сохраненные статьи. Каждый документ разбивается на чанки и эмбеддится локально.

Ollama, будь то через CLI или интерфейс, дорабатывает существующий обзор, а не пишет заново. MCP дает инструменты для поиска старых саммари и эмбеддингов. Модель находит изменения, переписывает нужные части, отмечает противоречия и устаревшее.

n8n коммитит обновленный обзор в репозиторий с диффом. Документ живет и развивается без ручных правок, на чистой локальной генерации.

Автоматические постмортемы инцидентов с привязкой к доказательствам

При закрытии инцидента n8n собирает таймлайн из алертов, логов и деплоев. Вместо слепого нарратива модель получает события в хронологическом порядке блоками.

Ollama пишет постмортем с явными ссылками на события таймлайна. MCP предоставляет fetch_event_details для докопывания деталей. Каждый абзац отчета ссылается на ID доказательств.

n8n отвергает выводы без ссылок и перезапускает промт. Итоговый документ точен, проверяем и не выводит операционные данные наружу.

Локальная автоматизация проверки контрактов и политик

Юристы и compliance запускают это на своих машинах. n8n берет черновики контрактов и обновления политик, убирает форматирование, делит на клаузы.

Ollama сравнивает клаузы с утвержденными шаблонами, отмечает отличия. MCP дает retrieve_standard_clause для стандартных формулировок. Вывод: точные ссылки, уровень риска, предложения правок.

n8n отправляет рискованное на проверку людям, неизменное — авто-принимает. Чувствительные файлы не покидают машину.

Код-ревью с использованием инструментов для внутренних репозиториев

Цепочка стартует на PR. n8n тянет диффы и результаты тестов, отдает Ollama с фокусом на логику и риски сбоев.

Через MCP модель вызывает run_static_analysis и query_test_failures, опирается на результаты для комментариев. n8n постит отзывы только при реальных, воспроизводимых проблемах.

Ревьюер не выдумывает мнения о стиле, комментирует только с фактами.

Итоговые выводы

Каждый пример сужает область модели, дает минимум инструментов, полагается на n8n для контроля. Локальная генерация обеспечивает скорость для постоянной работы и низкую цену. Главное — логика рядом с данными, исполнение под замком.

Здесь n8n, MCP и Ollama переходят из экспериментов в рабочий стек автоматизации.